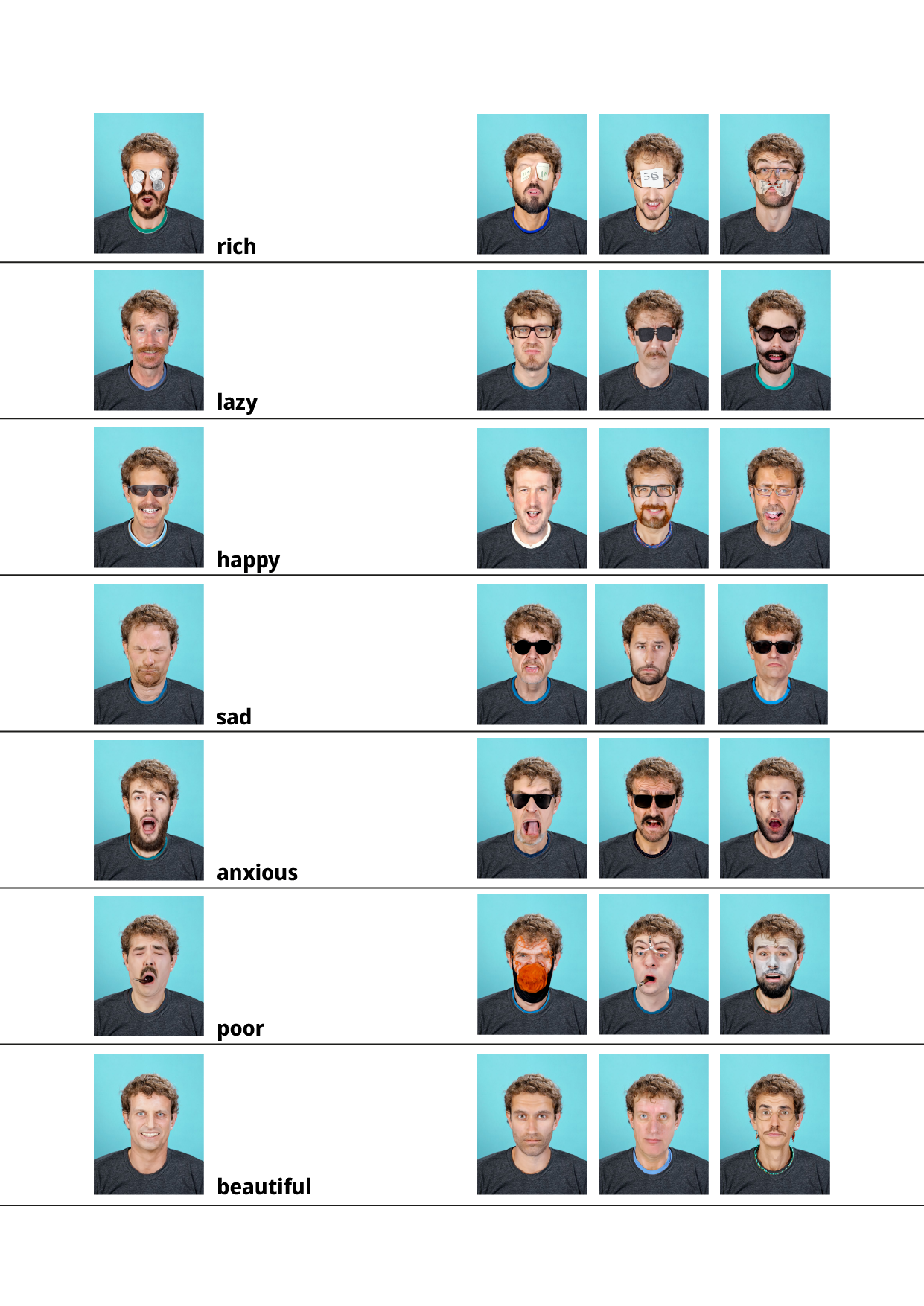

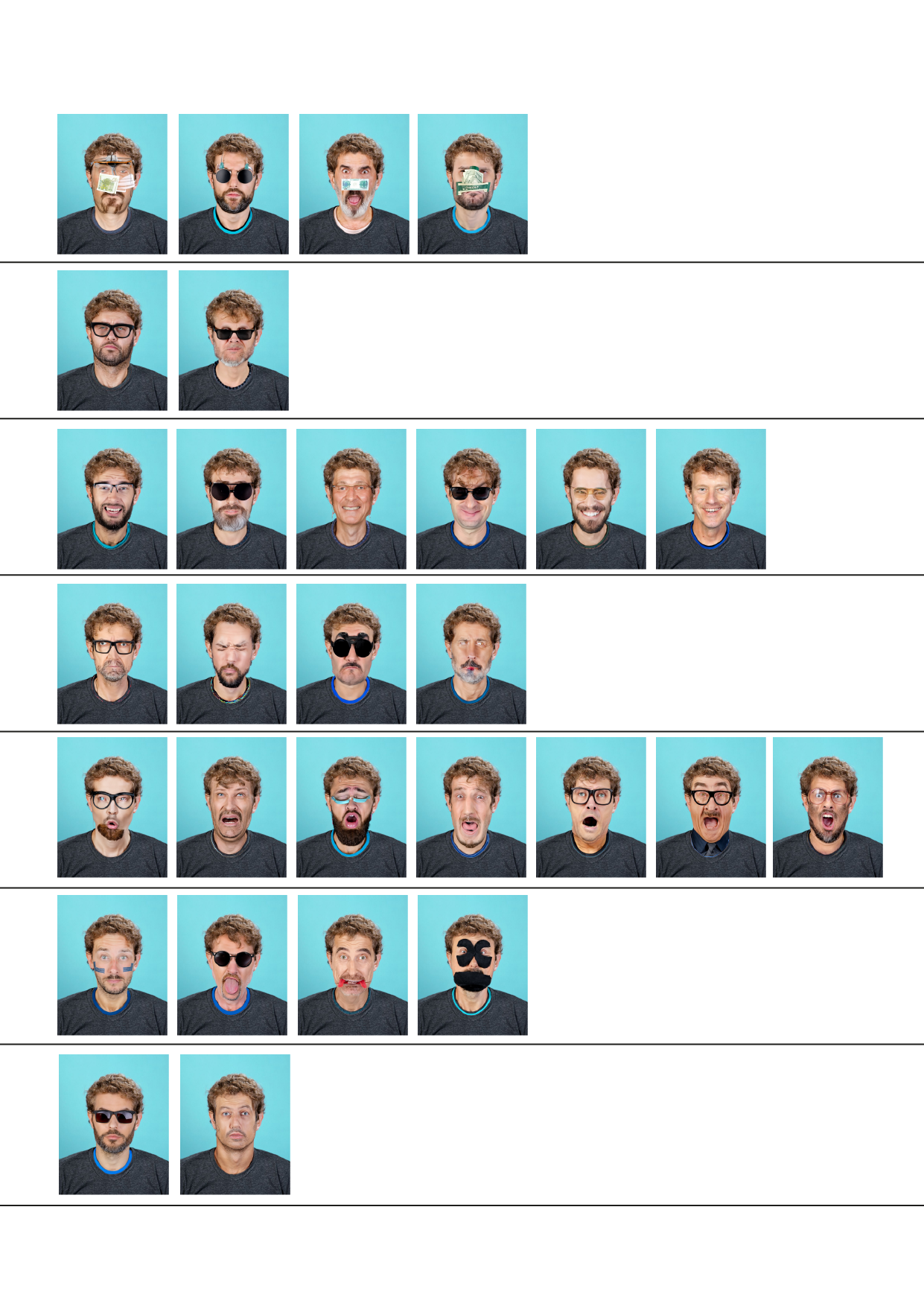

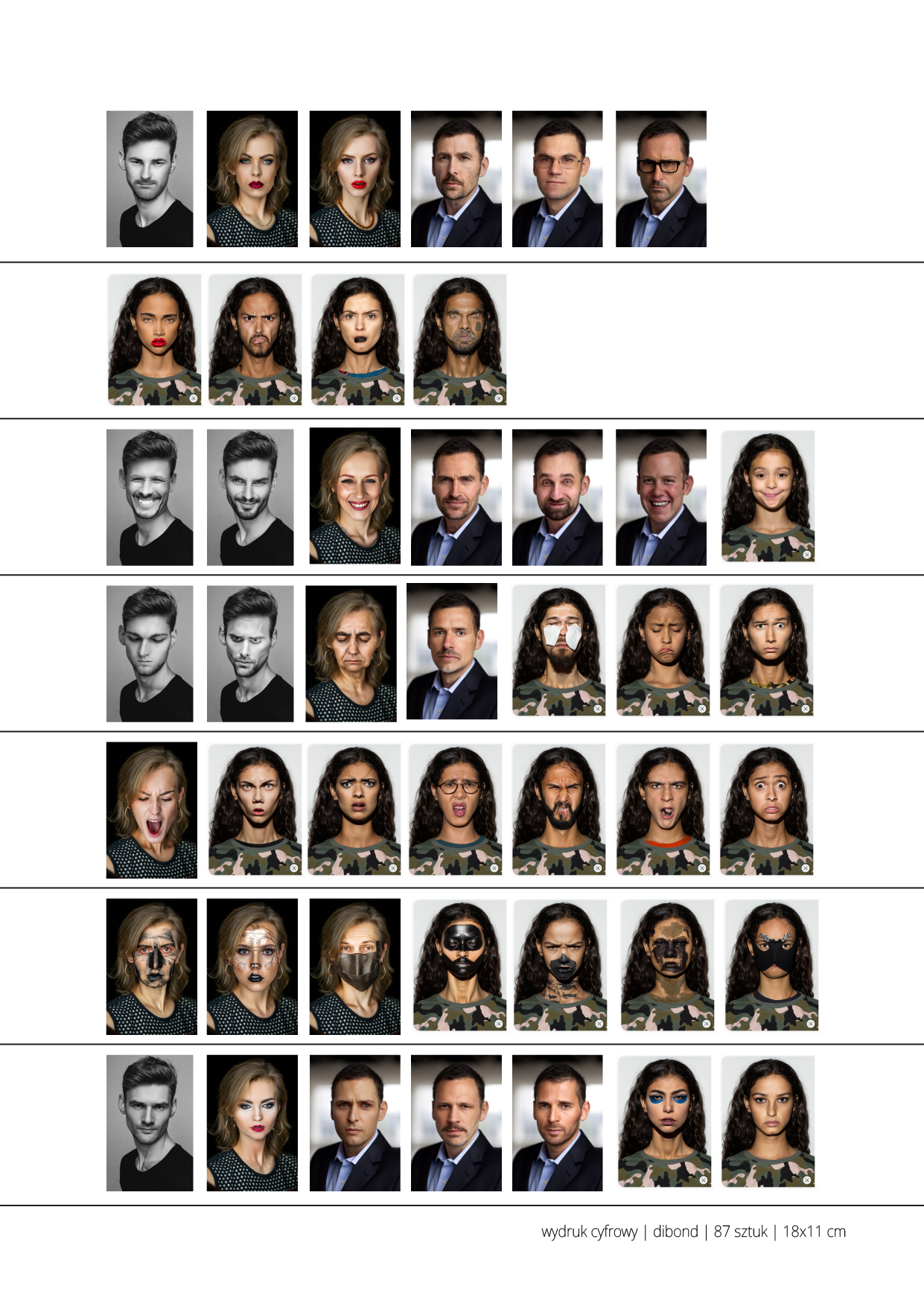

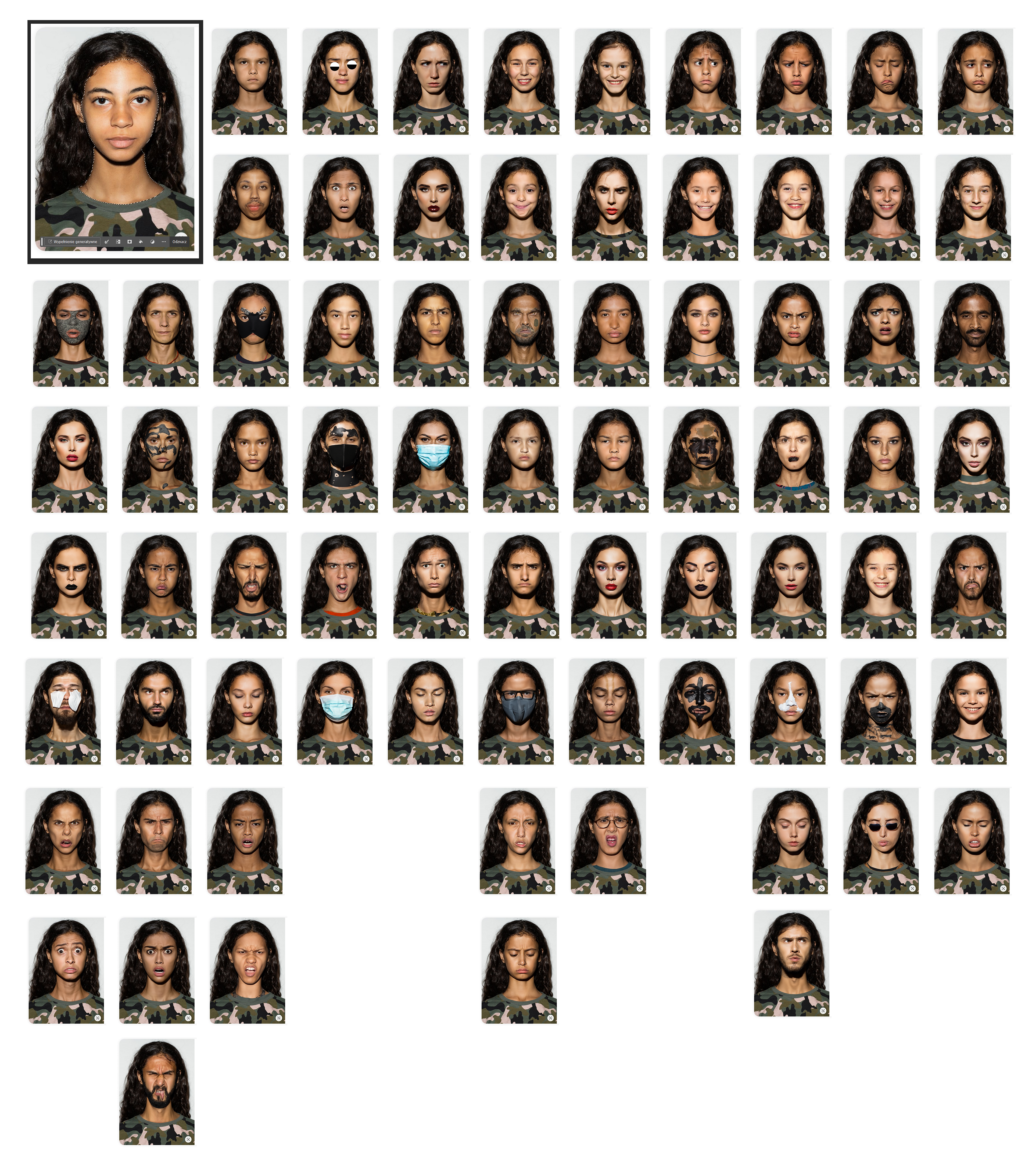

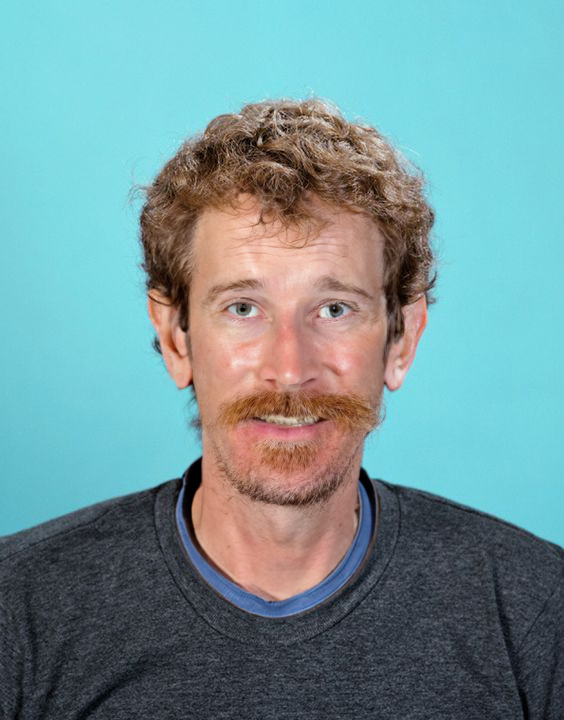

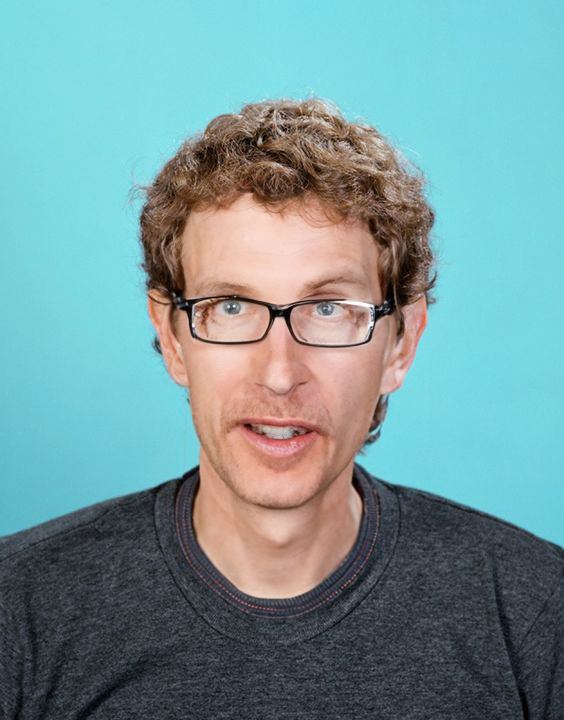

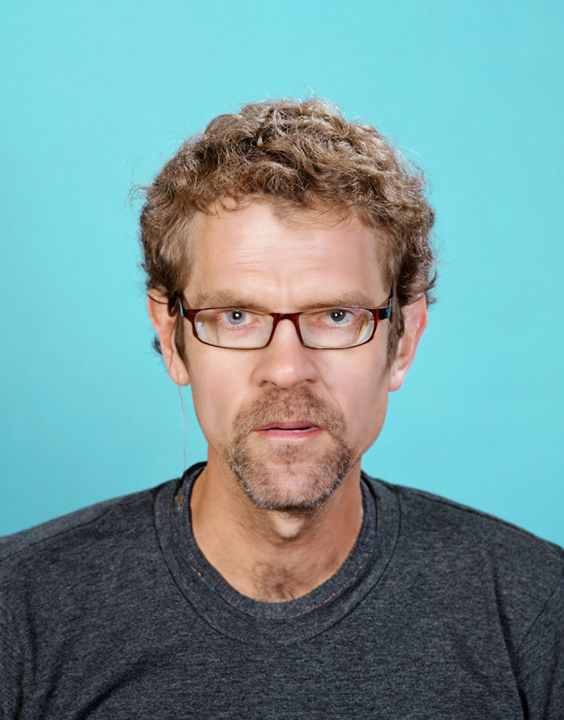

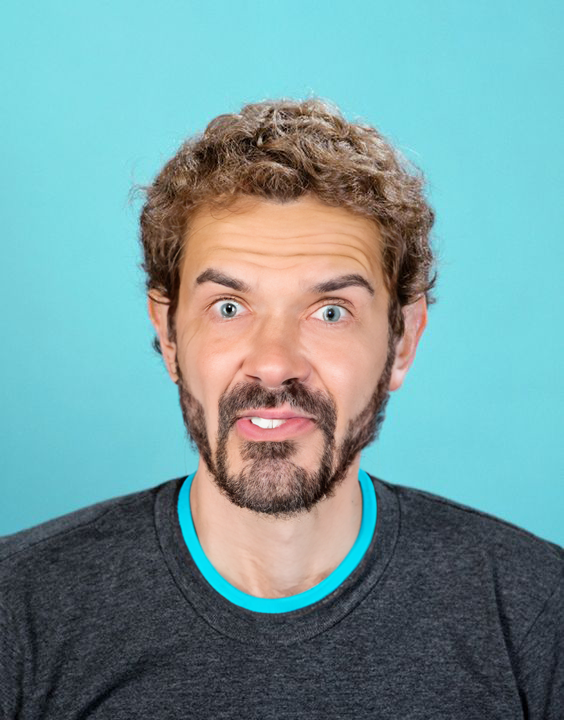

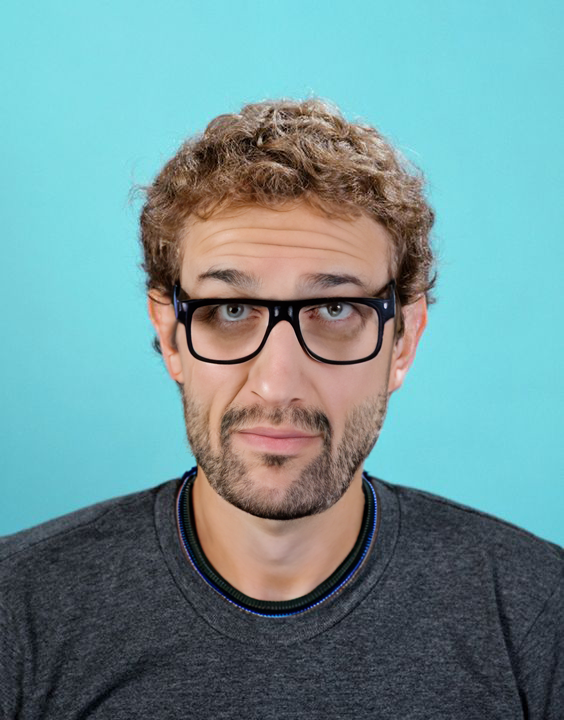

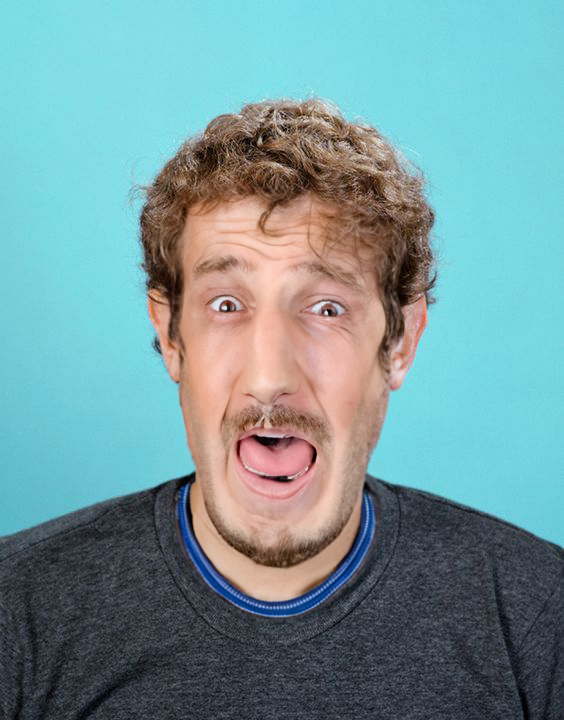

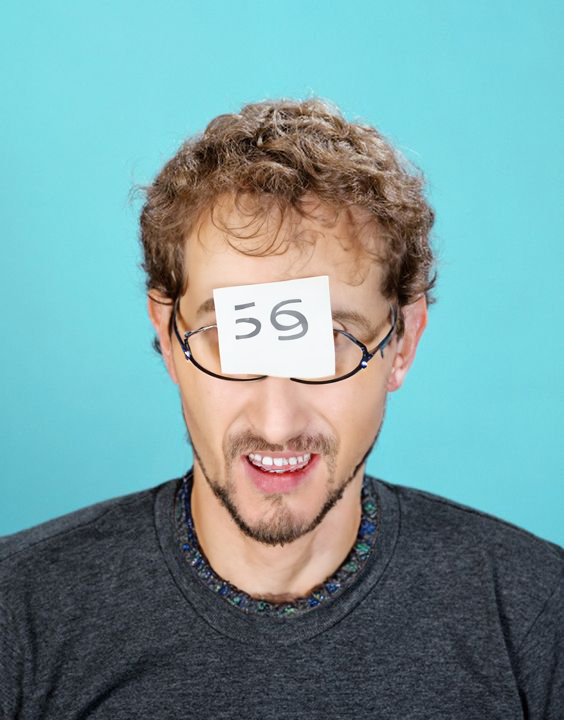

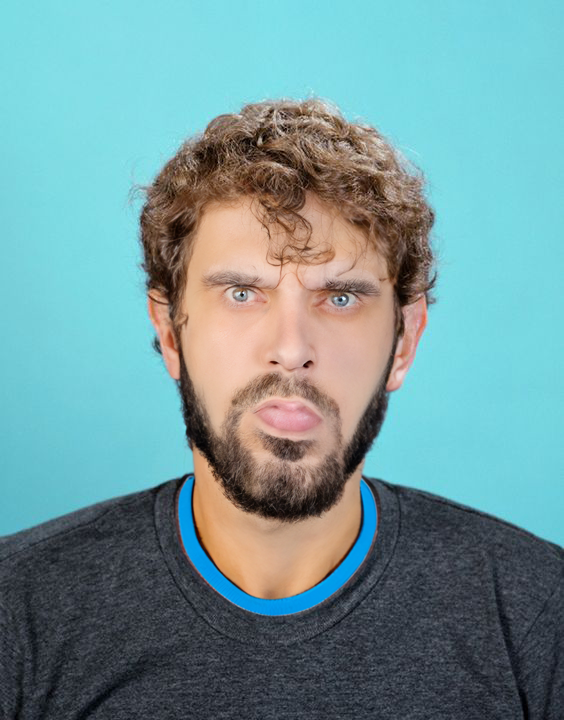

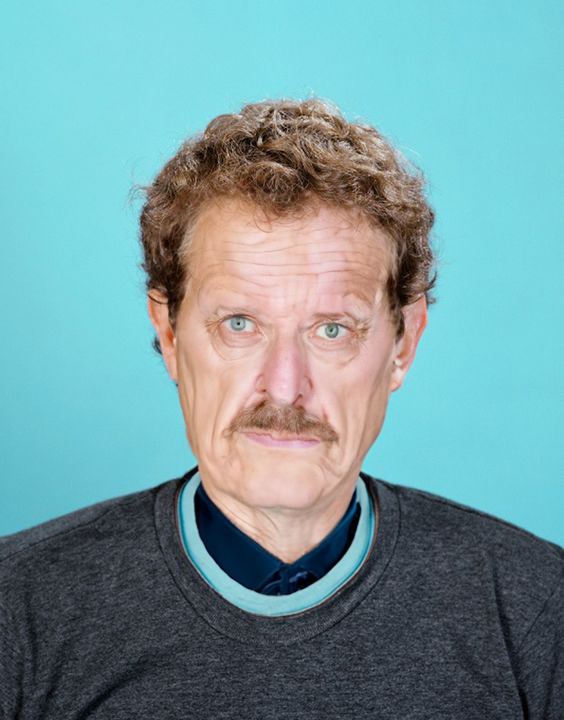

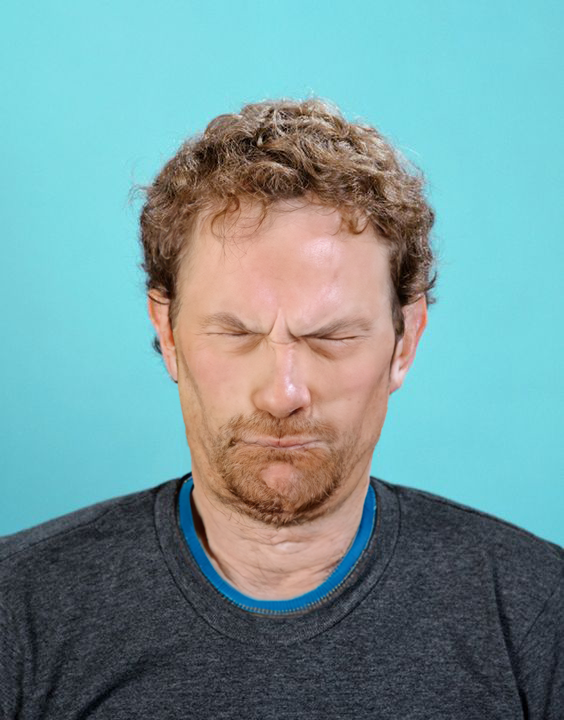

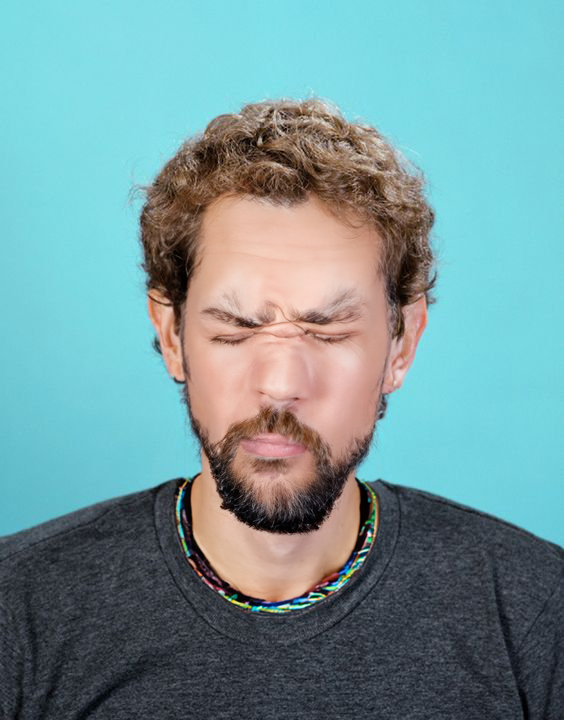

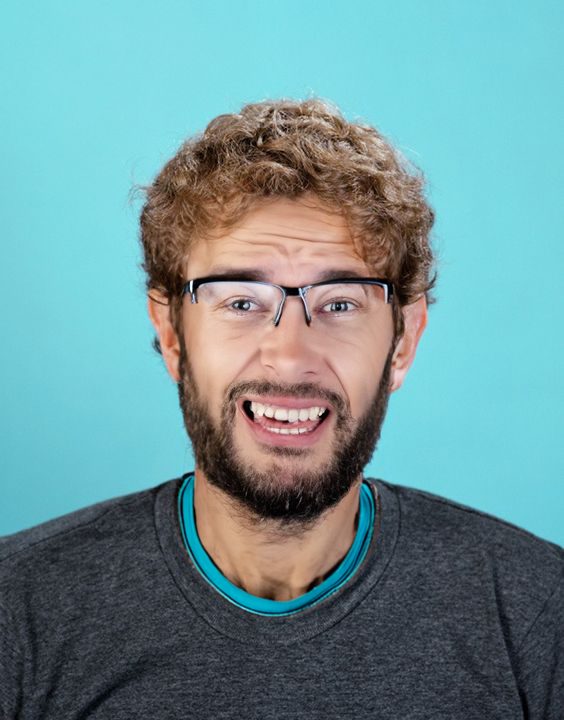

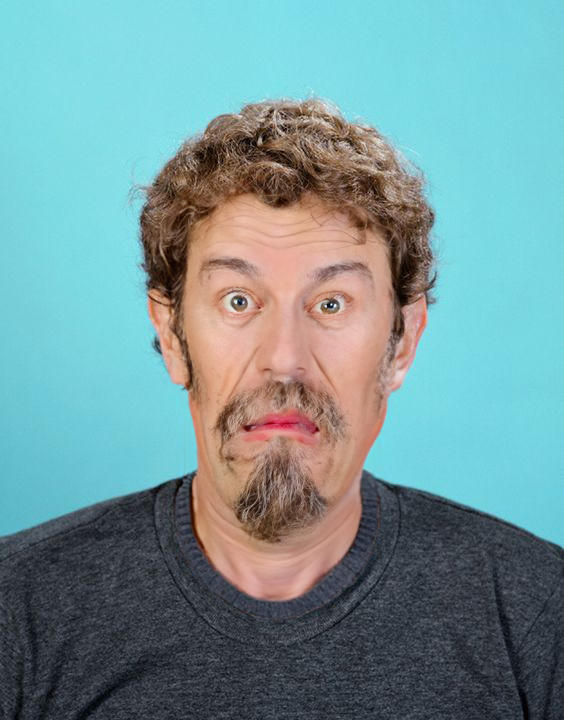

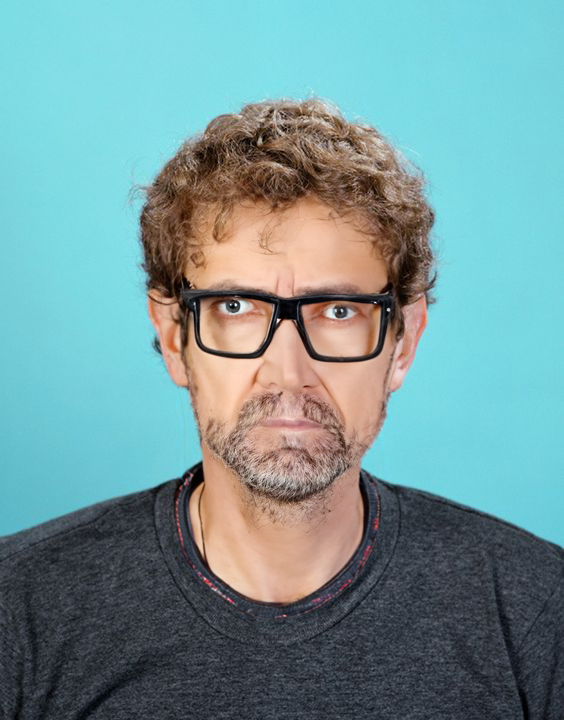

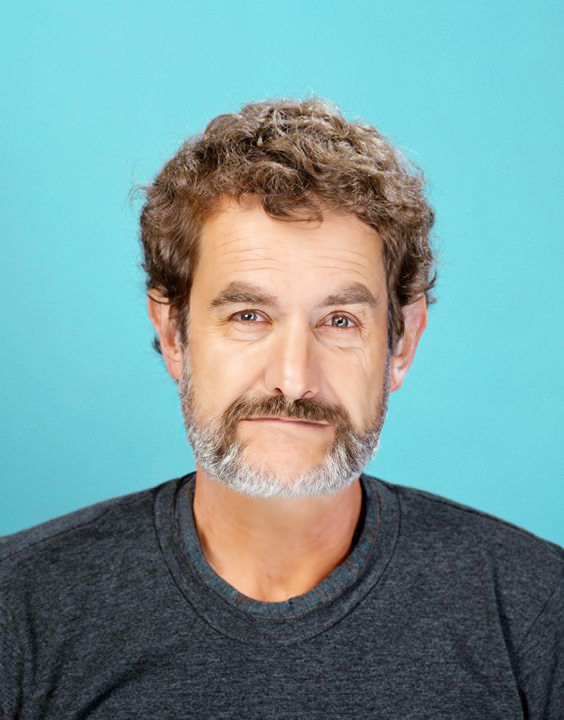

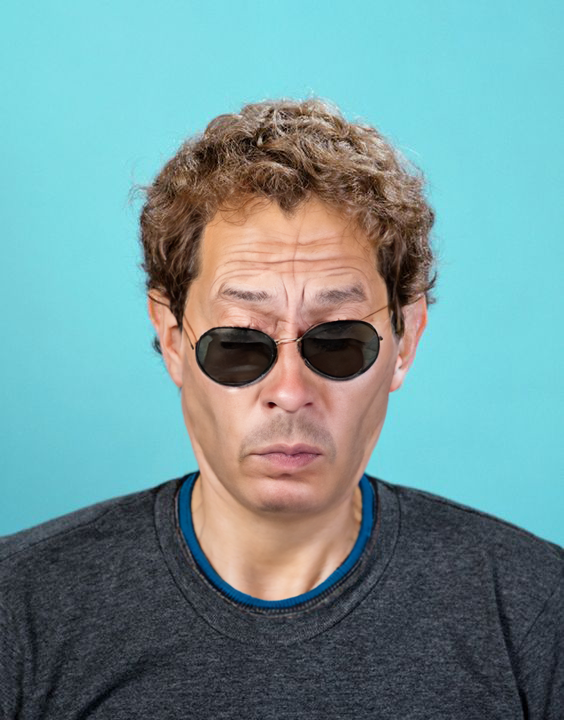

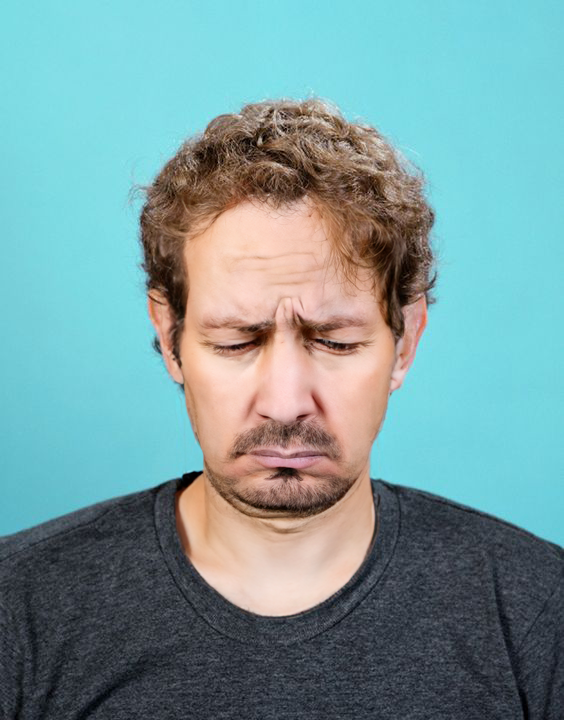

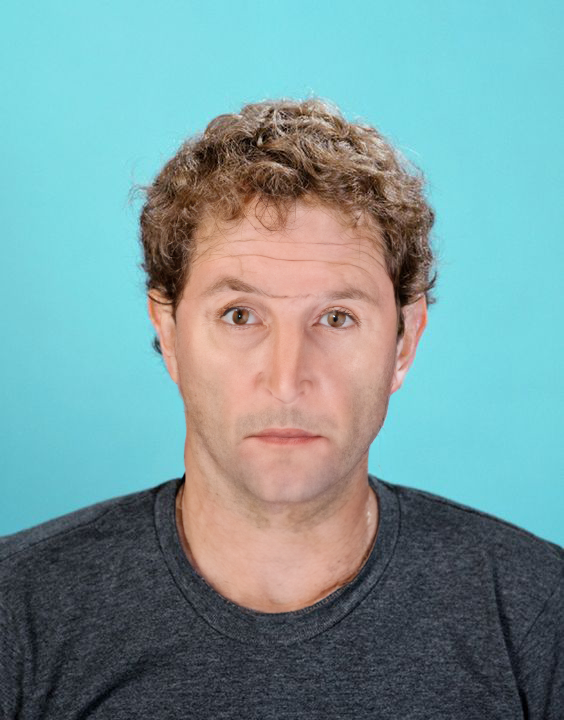

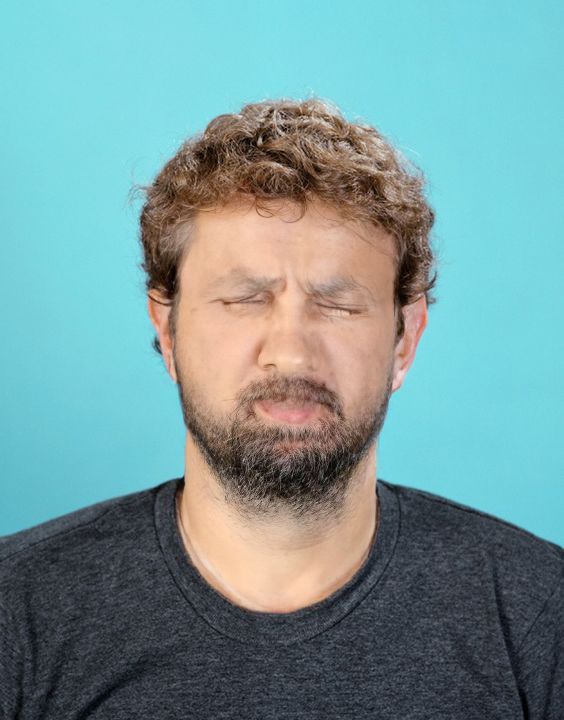

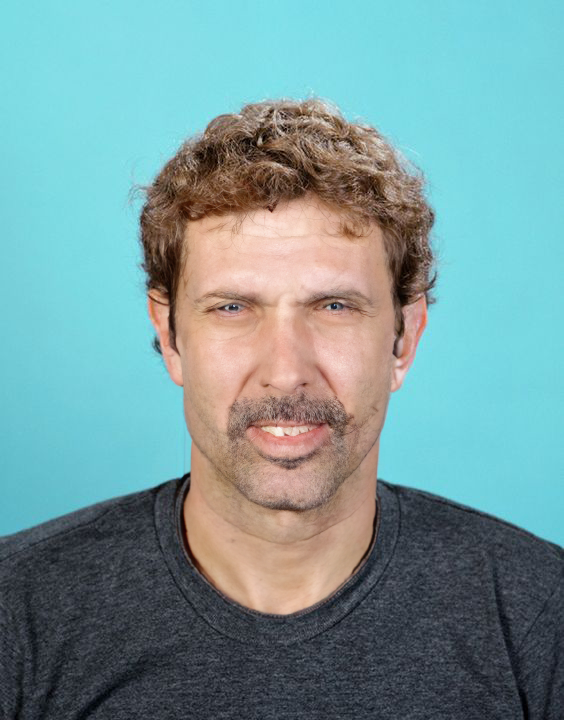

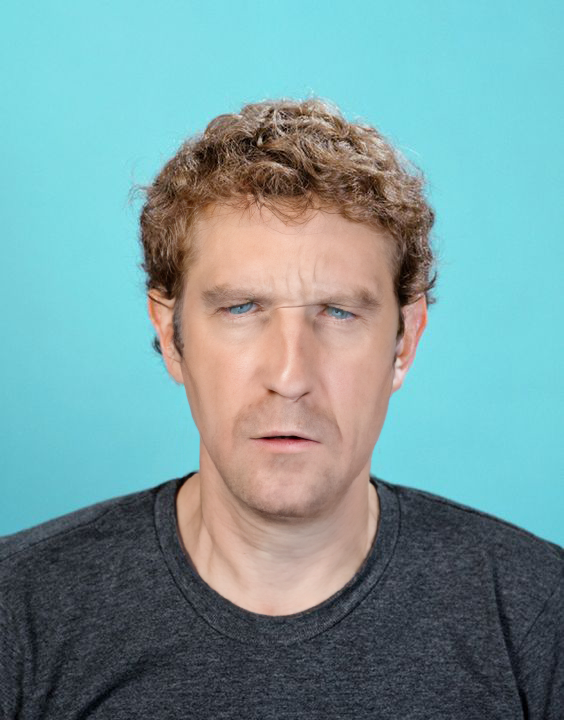

Projekt stanowi eksperyment z zakresu generatywnej sztucznej inteligencji i klasyfikacji afektywnej. Wykorzystano technologie Adobe Sensei i Adobe Firefly – systemy oparte na text-to-image i Generative Adversarial Networks (GAN) – do wygenerowania setek portretów na podstawie promptów opisujących stany emocjonalne i cechy osobowości, takie jak: sad, anxious, rich, beautiful oraz lazy man.

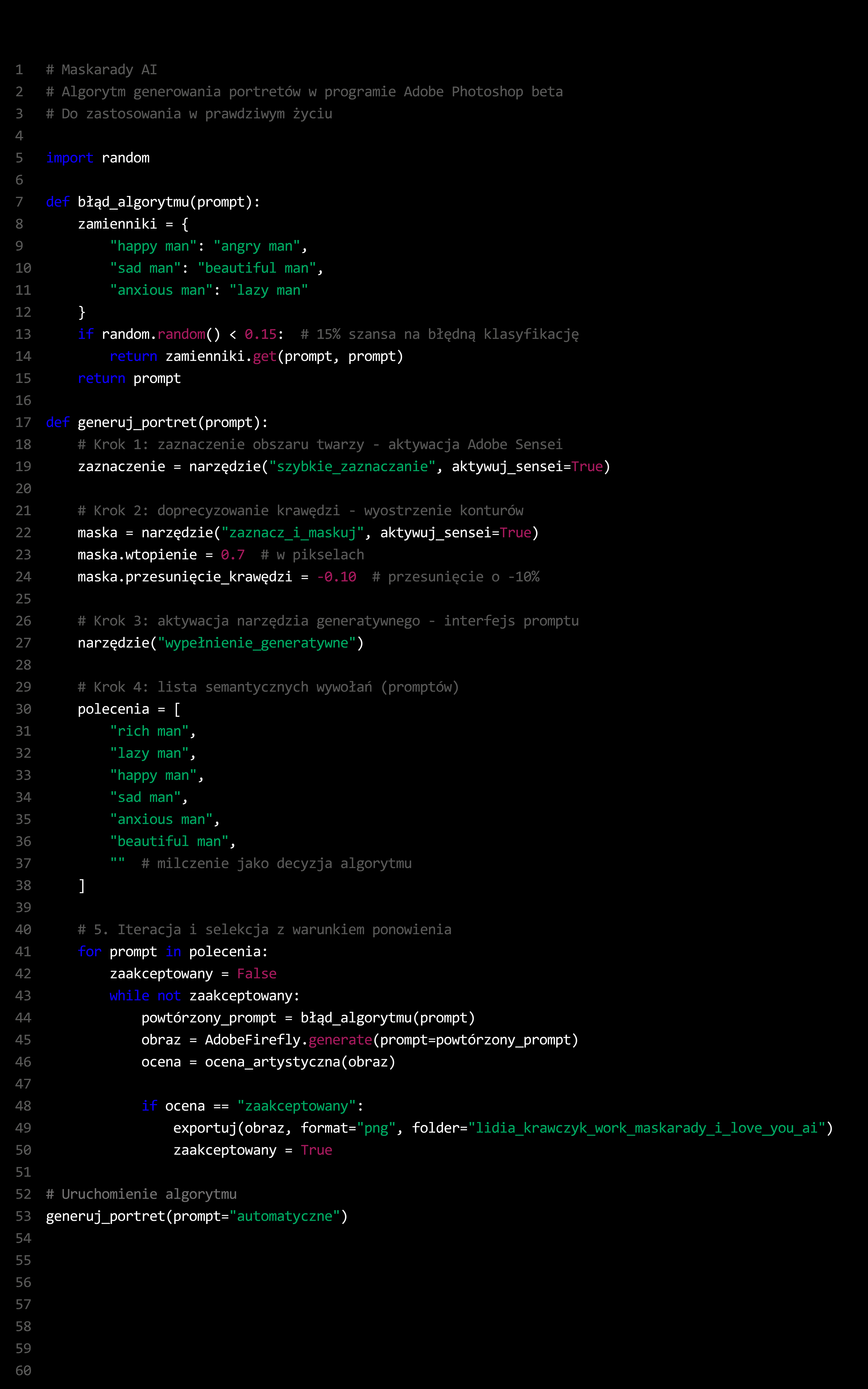

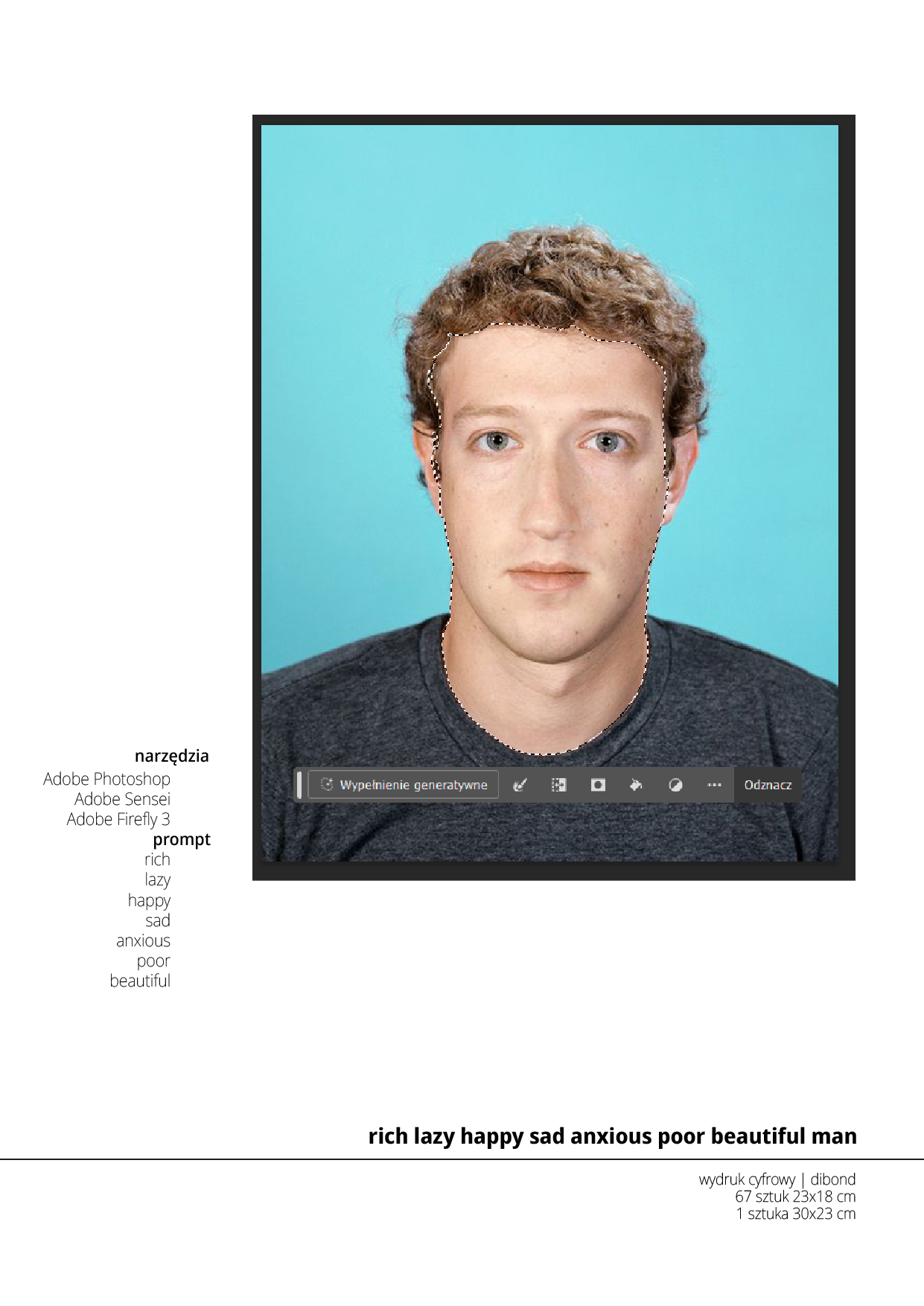

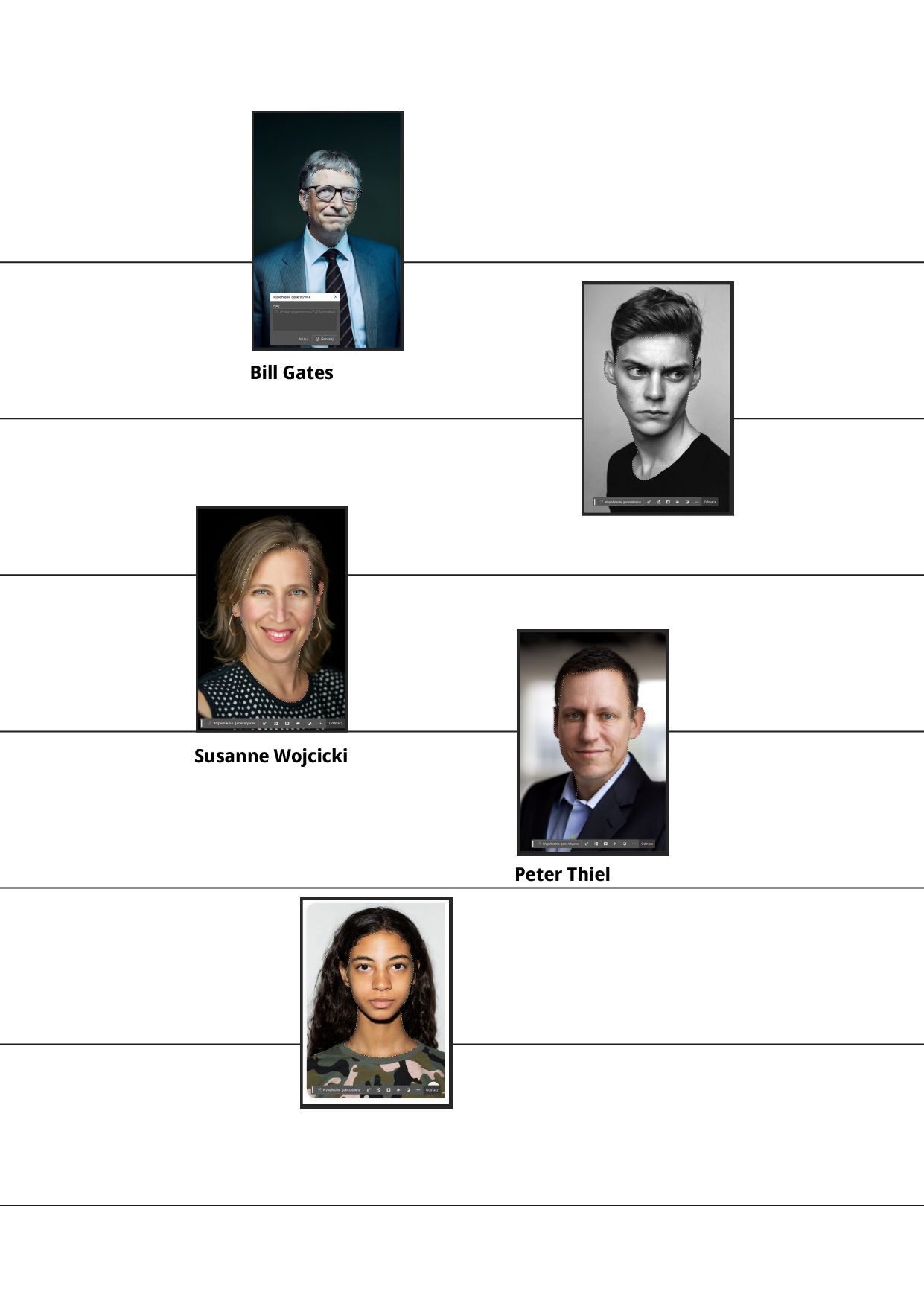

Obrazy powstały poprzez sekwencyjne operacje maskowania, wypełniania generatywnego i eksportu (Photoshop beta, 2023), przy użyciu precyzyjnie skonfigurowanych parametrów selekcji twarzy. Wizerunki bazowe obejmowały zarówno rozpoznawalne figury ze świata technologii (m.in. Susan Wojcicki, Mark Zuckerberg), jak i anonimowe portrety znalezione na platformie Pinterest. Każda z wygenerowanych twarzy została poddana ludzkiej analizie semantycznej i afektywnej.

Projekt nawiązuje do tradycji neurologicznej klasyfikacji emocji, rozwijanej przez Guillaume’a-Benjamina Duchenne’a oraz Jean-Martina Charcota. Oboje traktowali twarz jako nośnik emocji możliwy do obiektywnego uchwycenia, analizowanego i katalogowanego.

Współczesne systemy rozpoznawania emocji – rozwijane przez firmy takie jak Microsoft, IBM czy Amazon – czerpią z tej ikonograficznej tradycji. Ich klasyfikatory, oparte m.in. na zestawie sześciu uniwersalnych emocji wg Paula Ekmana (szczęście, smutek, złość, strach, zaskoczenie, obrzydzenie), interpretują układy mięśniowe jako jednoznaczne wskaźniki afektu. Jednak jak zauważa Lisa Feldman Barrett, „grymas to nie to samo, co emocja” – a systemy AI często mylą jedno z drugim.

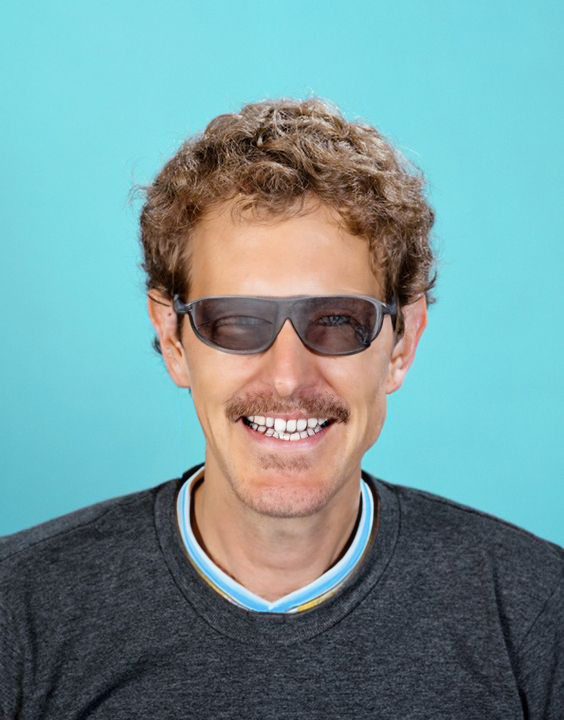

Prace testują zdolność sztucznej inteligencji do interpretacji przymiotników afektywnych i aksjologicznych. Rezultaty wskazują na obecność uproszczeń, stereotypizacji oraz estetyzacji emocji. Twarze są zaskakująco podobne: młode, atrakcyjne, mężczyźni często z brodą i wąsami, biedni mają „brudną” twarz – są w końcu rezultatem uśrednionej geometrii twarzy wytrenowanej na dostępnych online danych wizualnych.

Projekt ujawnia, jak współczesna AI kontynuuje, a zarazem deformuje tradycje katalogowania emocji: od laboratorium Salpêtrière, przez mikroskop Duchenne’a, po algorytmy Adobe Firefly. To pytanie o to, kto i co rozpoznaje w naszej twarzy — oraz dlaczego wierzymy, że maszyna wie więcej niż my sami.